Revue Droits et libertés

Publiée deux fois par année, la revue Droits et libertés permet d’approfondir la réflexion sur différents enjeux de droits humains. Réalisée en partenariat avec la Fondation Léo-Cormier, la revue poursuit un objectif d’éducation aux droits.

Chaque numéro comporte un éditorial, les chroniques Un monde sous surveillance, Ailleurs dans le monde, Un monde de lecture, Le monde de l’environnement, Le monde de Québec, un dossier portant sur un thème spécifique (droits et handicaps, droits des personnes aînées, police, culture, droit à l’eau, profilage, mutations du travail, laïcité, etc.) ainsi qu’un ou plusieurs articles hors-dossiers qui permettent de creuser des questions d’actualité. Les articles sont rédigés principalement par des militant-e-s, des représentant-e-s de groupes sociaux ou des chercheuses ou chercheurs.

Créée il y a 40 ans, la revue était d’abord diffusée aux membres de la Ligue des droits et libertés. Depuis, son public s’est considérablement élargi et elle est distribuée dans plusieurs librairies et disponible dans certaines bibliothèques publiques.

Bonne lecture !

L’inestimable valeur des droits humains

L’inestimable valeur des droits humains

Alexandra Pierre, présidente de la Ligue des droits et libertésBien commun

Les droits humains sont un bien commun. La COVID-19 a montré, de façon brutale, à quel point les droits humains concernent l’ensemble de la collectivité et combien ils ne peuvent être conçus et compris de manière strictement individuelle, mais requièrent très souvent des modes de mise en œuvre collective. L’impossibilité pour certaines personnes de faire respecter leurs droits au logement, à la santé, à la protection sociale, à un revenu décent et à la sécurité ainsi que la difficulté à rendre effectif le droit d’asile ou à de bonnes conditions de travail, tout cela met en péril, non seulement les droits des personnes, mais l’ensemble de la société. Pour développer une société plus juste, en mesure de surmonter ou d’éviter les crises, les droits humains servent de guide. Ils ne sont cependant pas la panacée : ils nécessitent que les États fassent face à leurs obligations de respect et de promotion des droits humains, qu’ils soient déterminés à soutenir la participation de leurs populations (particulièrement celle des groupes les plus marginalisés), comme l’exigent les différentes déclarations, pactes, conventions ou chartes et qu’ils soient imputables. Dans ce contexte, la compréhension de ce que sont les droits humains est primordiale, tout comme l’est le travail de résistance contre l’instrumentalisation du discours des droits humains à des fins contraires au principe d’interdépendance des droits.Décrédibiliser, banaliser, opposer

D’abord, la nature de ce que sont les droits humains est souvent manipulée et semble indéfiniment extensible. Toute situation est l’occasion d’évoquer un droit. Pensons à l’évocation politicienne des droits collectifs de la population québécoise pour imposer des décisions sur la base d’une majorité toute puissante, excluant ainsi une bonne partie de ceux et celles qui composent notre société. Par exemple, au nom des droits collectifs de la majorité, sans jamais pouvoir démontrer d’objectif réel et urgent pour la société québécoise en matière de laïcité, la Loi sur la laïcité de l’État (Loi 21) a sacrifié les droits et libertés des personnes de confession musulmane, particulièrement des femmes musulmanes, sur la base d’un discours erroné. Attaqués sur plusieurs fronts, les droits et libertés doivent être défendus. Pensons aux changements à la Charte par une simple majorité, à l’utilisation préemptive de la clause dérogatoire comme l’a fait le gouvernement du Québec avec la Loi 21, escamotant ainsi les débats tant dans l’arène politique que judiciaire, aux mobilisations du droit à la liberté d’expression, instrumentalisé par les mouvements de la droite identitaire pour justifier la propagation de leurs discours haineux à l’endroit des minorités, et notamment des personnes immigrantes et racisées. Les exemples sont aussi nombreux qu’inquiétants. Un autre des mécanismes de banalisation des droits humains consiste à les considérer comme optionnels. On l’a vu lors du recours prolongé à l’état d’urgence sanitaire durant la pandémie où la gouvernance autoritaire était peu compatible avec le respect de l’ensemble des droits humains : ces derniers n’étaient jamais évoqués lors des prises de décisions. Même scénario au moment venu de la relance : malgré les violations massives de droits subies durant la pandémie par les personnes aînées, dans les quartiers racisés, par les personnes en quête de logement adéquat ou en situation d’itinérance, par les personnes dont le travail était dit essentiel, etc., la nécessité d’assurer les droits, notamment les droits sociaux garantis par la Charte, ne faisait pas partie des priorités. Une autre manière de décrédibiliser les droits humains consiste à les opposer entre eux. Dans les prochaines négociations entre le gouvernement et les personnes employées dans le secteur public, on se fera certainement servir l’argument de la mise en concurrence entre le droit d’association (c’est-à-dire le droit d’exister des syndicats) et le droit de la population à des services de santé abordables. De même, à l’été 2021, les personnes habitant près de la Fonderie Horne étaient souvent mises devant ce faux dilemme : droit à la santé ou droit au travail ? Droit à un environnement sain ou droit à un revenu décent? Ainsi, les droits humains sont souvent dépeints comme des obstacles au développement économique ou à la prise de décision rationnelle. Dans cette même veine, un certain vocabulaire entourant les droits humains participe aussi à la tentative de disqualification : droits fondamentaux, droits de base, etc. Les droits humains doivent être traités sur un pied d’égalité et en leur accordant la même importance. Par exemple, le droit à l’éducation ne peut exister sans le droit à la santé et ce dernier ne peut s’accomplir sans droit au logement. De même, les mauvaises conditions de logement, de travail ou environnementales affecteront le droit à la dignité comme celui à la sécurité. Sans nier les tensions qui restent à résoudre, qui doivent être résolues, il est erroné (et risqué) d’opposer les droits entre eux comme on l’entend souvent dans l’espace public. La dignité humaine n’est pas morcelable : le seul équilibre se trouve dans le principe de l’interdépendance des droits où il n’existe pas de hiérarchie entre les droits.Promotion des droits

Ces différentes façons de banaliser le cadre de référence des droits humains illustrent à quel point la promotion des droits est essentielle pour comprendre les potentialités et l’importance des outils nationaux et internationaux existants. Déclarations, pactes, conventions ou chartes, tribunaux, commissions sont des outils précieux, mais encore faut-il en comprendre la portée et savoir comment ils peuvent être utiles pour assurer la dignité de tous et toutes. Ces mécanismes de décrédibilisation des droits humains démontrent aussi l’importance de pleinement saisir le principe d’interdépendance des droits, pour ne pas tomber dans certains pièges et pour rappeler les gouvernements à l’ordre lorsque nécessaire. Ainsi l’avenir des droits humains passe par la promotion des droits pour en saisir la puissance, pour les défendre, les étendre et, pourquoi pas, en assurer de nouveaux. Ce potentiel de puissance sera fort utile pour relever les défis des discriminations systémiques, des violations des droits sociaux et des crises environnementales ; bref, pour tendre vers la justice sociale. Ces luttes pour les droits et pour la promotion des droits ne peuvent être que collectives ; elles demandent discussions et délibérations. Les citoyen-ne-s (au sens civique du terme), les syndicats, les établissements d’éducation, et évidemment les organismes communautaires comme la Ligue des droits et libertés ont bien sûr un rôle à jouer dans ce chantier. Pour la suite du monde, l’heure n’est pas à la banalisation ou à la fragilisation des droits humains, mais bien à leur valorisation et à celle des outils qui les protègent pleinement ; cela passe aussi par la mobilisation continue de tous les groupes et mouvements sociaux engagés dans leur promotion.L’article L’inestimable valeur des droits humains est apparu en premier sur Ligue des droits et libertés.

La liberté d’expression dans tous ses états

Liberté d'expression et droit de manifester

Laurence Guénette, Coordonnatrice de la LDLRetour à la table des matières Revue Droits et libertés, printemps / été 2023

La défense du droit de manifester a été au cœur du travail de la Ligue des droits et libertés (LDL) en matière de liberté d’expression, étant donné qu’il s’agit d’une condition essentielle à la vitalité des mouvements sociaux et à l’émergence de puissantes mobilisations pour défendre les droits humains. Il est évident que les efforts pour protéger ce droit se poursuivront, s’adaptant aux enjeux contemporains et à venir, et que la vigilance est de mise devant toute limitation à ce droit à travers l’encadrement des manifestations ou devant la répression multiforme subie par les personnes qui manifestent. Cependant la liberté d’expression ne se limite pas à ce droit. Il s’agit aussi du droit d’exprimer des idées et des opinions, et de connaitre et d’entendre les idées et les opinions des autres1. Dans les dernières années, plusieurs débats ont secoué l’espace public, tentant de situer la frontière légale, légitime ou souhaitable entre cette expression des idées et opinions, et le respect des droits des personnes à ne pas subir de propos méprisants, haineux ou incitant à la violence à leur égard. Le débat a occupé tant l’arène publique et médiatique que l’arène judiciaire. On pense notamment à l’affaire Mike Ward, un humoriste s’étant moqué publiquement d’un jeune en situation de handicap, cas pour lequel un tribunal a dû déterminer s’il avait subi une discrimination fondée sur son handicap ou non. On pense aussi aux débats entourant l’utilisation du mot en N qui continuent de faire couler beaucoup d’encre à ce jour, par exemple à savoir si ce mot devrait être banni du vocabulaire utilisé par les réseaux publics de radiodiffusion, ou encore à savoir si un mot en N contenu dans le titre d’une œuvre littéraire demeure pour sa part acceptable. Pour la LDL, ces débats entourant la liberté d’expression invitent à des questionnements plus vastes qu’il est essentiel de réfléchir en cohérence avec d’autres luttes pour les droits humains. Les paragraphes suivants proposent en toute humilité certaines réflexions qui semblent pertinentes pour l’avenir.

Assiste-t-on à une instrumentalisation de la liberté d’expression ?

Ces dernières années, la notion de liberté d’expression a été brandie par plusieurs pour justifier de tenir des propos qui participent d’une violence vécue, pour protéger coûte que coûte le droit de quiconque de dire ce qui lui chante. L’expression coûte que coûte revêt son importance ici, car les impacts sont parfois graves. Pour les personnes marginalisées ciblées directement ou indirectement par ces propos, le fardeau est considérable. Dans le cas du « mot en N », des personnes Noires entendent ce mot qui porte un héritage ultra-brutal d’exactions déshumanisantes, un bagage révoltant nourri des violences racistes et colonialistes qui perdurent encore aujourd’hui. Certaines personnes choisissent d’exprimer publiquement leur malaise, de l’expliquer patiemment et de revendiquer de ne plus avoir à entendre ce mot violent. Finalement, certaines d’entre elles subissent dans l’espace public un contrecoup ou backlash virulent et attentatoire à leurs droits. Ainsi, un fardeau susceptible d’être porté en trois temps. Mais d’envisager toute limitation, et même autolimitation, dans l’usage de certains propos est perçue par certaines personnes comme une censure absolument intolérable. En 2018, la LDL constatait déjà que la liberté d’expression était au cœur de l’argumentaire des personnes souhaitant coûte que coûte préserver la possibilité de dire n’importe quoi : «nous observons actuellement une montée des discours racistes, anti-immigration, islamophobes et autres en dissonance avec le respect des droits humains. Lorsque critiqués, les porteurs de ces discours brandissent souvent leur liberté d’expression comme bouclier2». Par exemple, en 2017, des groupes de droite et d’extrême droite s’opposaient à une Motion contre l’islamophobie déposée à la Chambre des communes du Canada (M-103), alléguant que celle-ci bafouait leur liberté d’expression3. Dans ce contexte, la liberté d’expression n’est-elle pas instrumentalisée pour délégitimer les revendications des populations marginalisées pour le respect de leur droit à la dignité et à la non-discrimination ? Dans la foulée des luttes contre les différentes dimensions et manifestations du racisme systémique, il est nécessaire de reconnaitre qu’il existe aussi des inégalités dans l’accès à la prise de parole dans l’espace public. Certaines voix sont plus entendues et écoutées que d’autres ; certaines, les personnes racisées en l’occurrence, subissent un backlash déferlant que d’autres n’ont pas à craindre… Dans une perspective d’interdépendance des droits humains et de lutte contre le racisme systémique, la liberté d’expression doit être mobilisée davantage dans sa dimension collective et démocratique, et préservée de cette regrettable instrumentalisation. Là où elle aide à amplifier la voix des communautés marginalisées ; là où elle contribue positivement aux luttes sociales ; là où elle permet de garder vivant un discours critique, de contestation sociale, de contre-pouvoir, c’est là que la liberté d’expression est un atout pour une société juste et inclusive.La liberté d’expression et les technologies numériques

Notre époque témoigne aussi du foisonnement de propos haineux et de contenus dommageables en ligne, alors que les réseaux sociaux servent de tribune et d’amplificateur à tous les discours existants, y compris les discours racistes et misogynes. La LDL s’intéresse d’ores et déjà à ces questions, dans le cadre de son implication dans le mouvement de vigilance face à la surveillance des populations et aux usages de l’intelligence artificielle potentiellement attentatoires aux droits et libertés. La législation, ici comme ailleurs, accuse un important retard en ce qui a trait à l’encadrement de l’univers numérique et des réseaux sociaux, pendant que les nouvelles technologies et plateformes foisonnent sans balises et à une vitesse folle. Au moment d’écrire ces lignes, le gouvernement fédéral planche toujours sur un projet de loi visant à limiter les dommages en ligne. La LDL et plusieurs groupes, forts de leur travail et de leurs analyses en coalition, interviennent en amont des propositions législatives pour identifier et exiger certaines balises essentielles pour garantir la liberté d’expression dans la foulée de ce besoin d’encadrement. On peut aisément imaginer les écueils : que les encadrements, trop généraux, trop intrusifs ou délégués aux plateformes numériques, aient pour effet de limiter l’expression de certaines positions politiques (par exemple, que des positions critiques de l’État d’Israël soient censurées, car qualifiées à tort de terroristes ou d’antisémites). La LDL et d’autres groupes s’intéressant à cette nouvelle menace à la liberté d’expression soutiennent que les efforts de limitation des dommages en ligne doivent aller de pair avec des efforts de lutte contre le racisme systémique en amont et de façon vaste, dans un contexte où l’islamophobie et d’autres racismes particuliers se manifestent de façon accentuée depuis plusieurs années. De même, il importe de combattre les diverses manifestations du sexisme pour contrer la misogynie en ligne. En somme, l’avenir des luttes pour défendre la liberté d’expression, si on souhaite ces luttes porteuses de justice sociale et d’inclusivité, passe probablement par la dimension collective de ce droit, et non par le droit de quiconque d’exprimer toute chose, aussi offensante soit-elle. Elle devra être intimement liée à la lutte contre le racisme systémique et les autres systèmes d’oppression à l’œuvre dans nos sociétés, qui provoquent de nombreuses violations de droits. Sinon, nous risquons fort d’assister à une instrumentalisation de la liberté d’expression, qui nous éloignerait de la perspective de l’interdépendance des droits humains qui nous est chère.- Inspiré de la définition simplifiée proposée par Éducaloi.

- Vidéo, La liberté d’expression : pour tout le monde ? LDL, décembre En ligne : https://liguedesdroits.ca/liberte-dexpression-monde/

- Des manifestants de partout au Canada dénoncent la motion contre l’islamophobie, Radio-Canada, 4 mars 2017 https://ici.radio-canada.ca/nouvelle/1020369/manifestations-motion-islamophobie-canada-montreal

L’article La liberté d’expression dans tous ses états est apparu en premier sur Ligue des droits et libertés.

Défendre des espaces de contestation sociale

Liberté d'expression et droit de manifester

Lynda Khelil, Responsable de la mobilisation de la LDLRetour à la table des matières Revue Droits et libertés, printemps / été 2023

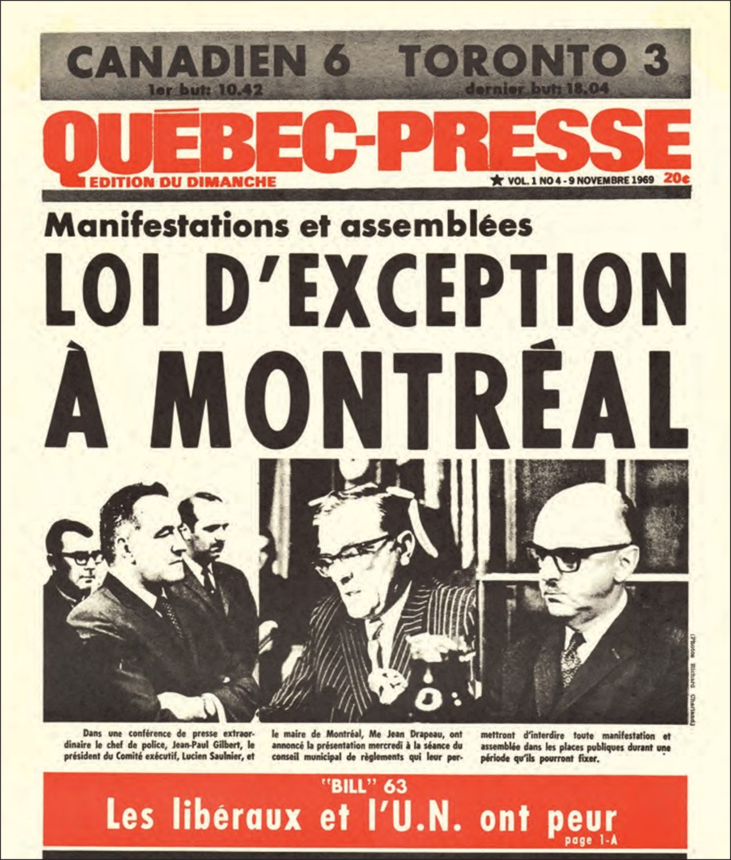

Dès les années 1960, la Ligue des droits et libertés (LDL) s’est penchée sur plusieurs cas de censure menaçant alors l’essor de perspectives progressistes, et féministes en particulier, au Québec. De tous temps, la LDL a dénoncé la répression policière et politique des contestations sociales. [caption id="attachment_17895" align="alignright" width="396"]

Québec-Presse, Archives UQÀM, Fonds LDL, 24p_630_02_D2_18[/caption]

Les mobilisations de la LDL pour le droit de manifester ont commencé dès sa création, en collaboration avec d’autres groupes, et avec des retombées concrètes pour l’exercice de ce droit. Dès 1969, la LDL s’oppose à l’adoption du règlement 3926 qui restreint le droit de manifester à Montréal. Sitôt adopté, sitôt utilisé : à la demande du chef de police de l’époque, l’administration de Jean Drapeau interdit la tenue de toute manifestation pour une durée de 30 jours. Le nouveau règlement est défié dans la rue et contesté devant les tribunaux, mais la Cour suprême confirme sa validité en 1978.

En 1994, il devient le règlement P-6, modifié en mai 2012 par l’administration du maire Gérald Tremblay pour obliger la divulgation de l’itinéraire à la police et interdire le port du masque. La LDL s’oppose à la modification de P-6 et exige son abrogation complète. La mobilisation s’échelonne sur plusieurs années, jusqu’à ce qu’enfin, le conseil municipal abroge le règlement P-6 en 2019, 50 ans après l’adoption de sa première mouture !

Québec-Presse, Archives UQÀM, Fonds LDL, 24p_630_02_D2_18[/caption]

Les mobilisations de la LDL pour le droit de manifester ont commencé dès sa création, en collaboration avec d’autres groupes, et avec des retombées concrètes pour l’exercice de ce droit. Dès 1969, la LDL s’oppose à l’adoption du règlement 3926 qui restreint le droit de manifester à Montréal. Sitôt adopté, sitôt utilisé : à la demande du chef de police de l’époque, l’administration de Jean Drapeau interdit la tenue de toute manifestation pour une durée de 30 jours. Le nouveau règlement est défié dans la rue et contesté devant les tribunaux, mais la Cour suprême confirme sa validité en 1978.

En 1994, il devient le règlement P-6, modifié en mai 2012 par l’administration du maire Gérald Tremblay pour obliger la divulgation de l’itinéraire à la police et interdire le port du masque. La LDL s’oppose à la modification de P-6 et exige son abrogation complète. La mobilisation s’échelonne sur plusieurs années, jusqu’à ce qu’enfin, le conseil municipal abroge le règlement P-6 en 2019, 50 ans après l’adoption de sa première mouture !

Répression effarante des grands événements

En avril 2001, le Comité de surveillance des libertés civiles de la LDL organise une mission d’observation indépendante au Sommet des Amériques à Québec et témoigne d’une répression policière effarante. 900 balles de plastique sont tirées et 5 000 bombes de gaz lacrymogènes sont lâchées sur les manifestant-e-s et dans la ville. 430 personnes sont blessées et 480 sont arrêtées. La LDL publie un rapport exigeant l’interdiction immédiate de l’usage des balles de plastique lors de manifestations. La LDL est sur un pied d’alerte lors d’autres grands événements tels que le Sommet du G-20 à Toronto en 2010, où 1 140 personnes sont arrêtées et détenues, subissant des conditions de détention humiliantes et dégradantes incluant des fouilles à nu systématiques. Avec la Clinique internationale de défense des droits humains de l’UQÀM, la LDL présente un rapport à la Commission interaméricaine des droits de l’Homme à Washington, dénonçant cette répression sur la scène internationale. La LDL orga- nise aussi une mission d’observation conjointe avec Amnistie internationale Canada lors des manifestations en marge du G-7 à La Malbaie et à Québec en 2018. Entre 1996 et 2006, environ 3 000 personnes sont arrêtées lors de manifestations au Québec. La LDL se tourne vers le Comité des droits de l’homme et le Comité contre la torture des Nations Unies pour dénoncer l’emploi d’armes de contrôle de foule et la pratique de l’arrestation de masse par encerclement. Les recommandations des Nations Unies sont toutefois ignorées par les autorités, aucune enquête n’est décrétée, et l’usage de ces pratiques et armes de contrôle de foule décriées se poursuit. Au printemps 2012, le Québec est marqué par la plus longue grève étudiante de son histoire, qui est le théâtre d’une répression policière considérable. 3 500 personnes sont arrêtées et de nombreuses autres sont gravement blessées par la police. La LDL dénonce cette répression brutale ainsi que la judiciarisation de ces mobilisations d’envergure et réclame la tenue d’une commission d’enquête publique et indépendante sur les stratégies d’interventions policières et les violations de droits. Une pétition initiée par la LDL récolte plus de 11 000 signatures et est déposée à l’Assemblée nationale. En 2013, le gouvernement met en place une Commission d’examen des événements du printemps 2012 chargée d’analyser les circonstances des manifestations et des actions de perturbation survenues en 2012. La LDL dénonce aussitôt le détournement de sa demande qui était d’examiner les violations de droits commises par les forces policières et refuse d’y participer.Contestation et sensibilisation

Dans les années qui suivent, la LDL publie deux rapports importants sur le sujet : Répression, discrimination et grève étudiante (2013) en collaboration avec l’Association des juristes progressistes et l’Association pour une solidarité syndicale étudiante, et Manifestations et Répression (2015), un bilan du droit de manifester au Québec depuis 2011. En 2013, la LDL intervient devant les tribunaux dans la contestation de la constitutionnalité de l’article 500.1 du Code de la sécurité routière, une disposition utilisée par la police depuis 2011 pour faire des arrestations de masse. En 2015, la Cour d’appel invalide 500.1, une victoire importante ! En 2017 et 2022, la LDL s’investit dans le projet Le droit de manifester : les règlements municipaux sous la loupe en partenariat avec le Service aux collectivités de l’UQÀM et le Mouvement d’éducation populaire et d’action communautaire du Québec (MÉPACQ). Motivé par les préoccupations et besoins exprimés par divers groupes, le projet se penche sur les limites réglementaires imposées à l’exercice du droit de manifester. En plus de la publication d’un guide en 2017 et d’une tournée d’ateliers, le site Web droitdemanifester.ca est lancé en 2021. Près de 1 000 municipalités sont contactées et invitées à réviser leur règlementation afin de retirer les dispositions qui entravent l’exercice du droit de manifester. Plusieurs victoires s’en suivent, certaines municipalités répondent à l’appel en abrogeant des dispositions réglementaires problématiques, telles que Terrebonne en avril 2023.Luttes contre les poursuites-bâillons

Au cours des années 2000, la LDL se mobilise autour du phénomène des poursuites-bâillons, une entrave majeure à la liberté d’expression, menaçant la participation démocratique et l’espace de contestation occupé par les mouvements sociaux. Ce sont des poursuites abusives contre des groupes participant au débat public et constituant « une instrumentalisation, même un détournement, du système judiciaire1 ». Plusieurs cas emblématiques ont alimenté les analyses et mobilisations, notamment la poursuite contre l’Association québécoise de lutte contre la pollution atmosphérique (AQLPA) en 2005 qui a engendré la campagne Citoyens, Taisez-vous !. Puisque les groupes écologistes sont souvent la cible de poursuites abusives, cette mobilisation d’envergure s’est faite en coalition avec le Réseau québécois des groupes écologistes (RQGE), notamment. L’adoption de la Loi modifiant le Code de procédure civile pour prévenir l’utilisation abusive des tribunaux et favoriser le respect de la liberté d’expression et la participation des citoyens aux débats publics, en 2009, est indéniablement le fruit de cette lutte qui est parvenue à doter le Québec d’une loi parmi les plus robustes au monde ! La LDL et le RQGE mènent alors une tournée de formation à travers la province pour aider les groupes à se saisir de ce nouvel outil juridique. Depuis 2009, l’efficacité de la loi a été constatée à de nombreuses reprises, protégeant effectivement certains militant-e-s et groupes contre des tentatives de poursuites-bâillons. Néanmoins, la loi comporte aussi certaines limites. La LDL et les groupes écologistes, entre autres, doivent donc demeurer vigilant-e-s et mobilisé-e-s devant toutes les tentatives de recours judiciaires qui n’ont pas « pour premier but de gagner en cour, mais plutôt de réduire l’adversaire au silence, de l’épuiser financièrement et psychologiquement […] et de décourager d’autres personnes de s’engager dans le débat public2 ».- Audition de la LDL à la Commission des institutions, le 8 avril 2008, vidéo : https://www.assnat.qc.ca/fr/video-audio/archives-parlementaires/travaux-commissions/AudioVideo-8327.html?support=video

- Lucie Lemonde, Lutte contre les poursuites-bâillons : une réforme à poursuivre dans Marie-Pier Arnault et al, dir, L’accès à la justice, quelle justice ?, Nouveaux Cahiers du Socialisme, vol 16, 2016

L’article Défendre des espaces de contestation sociale est apparu en premier sur Ligue des droits et libertés.

60 ans de luttes pour les droits humains

Dossier

Paul-Etienne Rainville, Chercheur postdoctoral aux départements d'histoire de l'Université de Toronto et de l'Université de Montréal, membre du CA de la LDL et co-directeur du dossier de la revueRetour à la table des matières Revue Droits et libertés, printemps / été 2023

Aux origines d'un mouvement...

Aux origines d'un mouvement...

Si les droits humains sont en mouvements, c’est d’abord parce que leur reconnaissance (faut-il le rappeler?) ne se cantonne pas aux avancées juridiques et législatives, aussi essentielles soient-elles. Tributaire des rapports de pouvoir qui traversent nos sociétés, leur avancement est le fruit des combats contre tous les systèmes de domination et d’oppression qui empêchent leur réalisation pleine et entière. C’est pourquoi l’histoire de la Ligue des droits et libertés (LDL), loin de se cantonner aux arcanes des parlements et des cours de justice, plonge au cœur de l’histoire mouvementée des luttes pour faire avancer la justice et reculer les frontières de l’exclusion.

La fondation de la Ligue des droits de l’homme, le 29 mai 1963, est intimement liée à l’évolution des mouvements sociaux au Québec, dans la foulée de l’adoption de la Déclaration universelle des droits de l’homme de 1948. Dès 1937, Frank R. Scott, Jean-Charles Harvey et Raymond Boyer mettent sur pied la Société canadienne des droits de l’homme, en réaction à l’adoption de la loi du cadenas de Maurice Duplessis. Après la Deuxième Guerre mondiale, Frank R. Scott est toujours à l’avant-scène du combat contre cette loi anticommuniste arbitraire et liberticide, qu’il réussit à faire invalider dans une victoire retentissante en Cour suprême du Canada, en 1957. La célèbre militante féministe et fondatrice de la LDL, Thérèse Casgrain, milite également aux côtés de Frank R. Scott pour défendre les droits des femmes, les libertés civiles, les droits des minorités religieuses, et combattre la politique canadienne de déportation des citoyen-ne-s d’origine japonaise1.

Engagés dans les cercles libéraux, socialistes et réformistes des années 1950, les militant-e-s de la première heure à la LDL sont parmi les premier-ière-s au Québec à réclamer l’adoption d’une charte des droits et des enquêtes de l’Organisation des Nations Unies pour violations de droits humains dans la province. Pierre Trudeau, Jean Marchand, Gérard Pelletier, Gérard Rancourt et Jean-Louis Gagnon, parmi d’autres, fondent plusieurs groupes – dont le Rassemblement (1956) et l’Union des forces démocratiques (1958) – regroupant des militant-e-s de différents milieux engagés dans un combat commun contre ce qu’ils perçoivent comme une dégradation généralisée de la démocratie, de l’État de droit et des libertés civiles dans le Québec de la Grande Noirceur2.

C’est pourquoi l’histoire de la LDL, loin de se cantonner aux arcanes des parlements et des cours de justice, plonge au coeur de l’histoire mouvementée des luttes pour faire avancer la justice et reculer les frontières de l’exclusion.La première décennie d’histoire de la Ligue des droits de l’homme (comme elle s’appellera jusqu’en 1978) est fortement marquée par l’héritage des luttes contre les lois répressives, antiouvrières et liberticides de l’ère duplessiste. Formée d’avocat-e-s, de journalistes et d’intellectuel-le-s des milieux réformistes, la LDL s’implique principalement dans la défense des droits individuels, du droit à l’égalité, des droits des femmes et des droits civils et politiques. À travers cet engagement, ses membres prennent une part active dans les mouvements sociaux et dans les principaux chantiers de réforme de la Révolution tranquille. Dès sa fondation, la LDL accorde une attention soutenue aux enjeux qui touchent l’administration de la justice dans la province. Elle est en grande partie à l’origine de la mise sur pied, en 1967, de la Commission d’enquête sur l’administration de la justice en matière criminelle et pénale (Commission Prévost3). Ses membres dénoncent alors les procédures illégales, le mauvais traitement des détenu-e-s et les violations des droits civils et juridiques commises par la police, les procureur-e-s, les enquêtrices et enquêteurs et les magistrat-e-s dans l’application des lois et des procédures pénales au Québec. À la même période, la LDL réclame la mise sur pied d’un poste de Protecteur du citoyen (ombudsman) chargé de protéger les droits des citoyen-ne-s face à l’administration publique et l’instauration d’un système d’aide juridique destiné à favoriser l’égalité de toutes et tous dans l’accès au système de justice. Les membres de la LDL s’impliquent aussi activement dans les débats de l’époque sur la révision du Code civil. Après avoir défendu sans succès un projet de Charte des droits, présenté en 1964 par le constitutionnaliste Jacques- Yvan Morin, la LDL réclame l’inclusion de 10 articles (décalogue) énumérant les droits fondamentaux au sein du Code civil. À l’initiative des membres de son Comité sur les droits de la femme, la LDL lutte pour la reconnaissance de l’égalité juridique des femmes mariées, l’interdiction des discriminations dans l’accès aux professions et la révision des régimes matrimoniaux. Elle appuie également la campagne initiée depuis l’après-guerre par des membres des syndicats et des minorités ethniques et racisées pour réclamer l’interdiction de la discrimination raciale et religieuse au Québec. Période d’avancées majeures en matière de protection des droits humains, les années 1960 et 1970 sont aussi marquées par la surveillance et la répression des forces de la contestation et du changement social. Militant contre la censure et pour la liberté d’expression, la LDL se porte à la défense de militant-e-s nationalistes et de la gauche radicale arrêtés et emprisonnés (dont des membres du FLQ), qualifiés par plusieurs à l’époque de prisonniers politiques. Elle dénonce les brutalités commises par la police lors de plusieurs manifestations violentes, notamment celles du Samedi de la matraque dans le cadre de la visite de la reine Elizabeth II au Québec, en 1964, et de l’opération McGill français, en 1969. Cette année-là, la LDL multiplie les interventions pour dénoncer le règlement 3926 de l’administration du maire Jean Drapeau, qui confère au Comité exécutif le pouvoir arbitraire d’interdire toute manifestation sur le territoire montréalais. Ces combats pionniers pour la sauvegarde de la démocratie, de l’État de droit et des droits civils et politiques plongent au cœur des luttes sociales et politiques de l’époque. Ils sont, jusqu’à aujourd’hui, l’une des matrices fondamentales de l’histoire de la LDL et de son engagement pour la défense des droits humains.

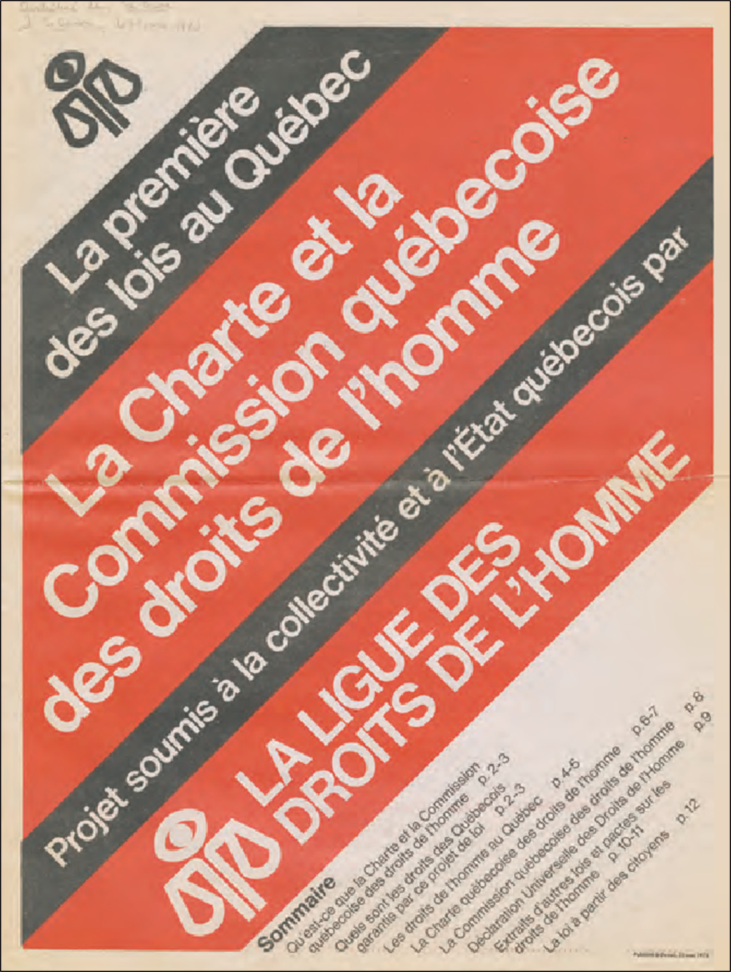

Un virage social…en appui aux mouvements sociaux

Le début des années 1970 marque un virage à la LDL, qui se positionne comme alliée des luttes menées par les syndicats, les groupes d’action politique et les milieux communautaires pour les droits des groupes « les plus démunis dans l’exercice de leurs droits fondamentaux4 ». À l’époque, ce virage social est principalement orienté vers la défense des personnes âgées, handicapées, pauvres, assistées sociales, chômeuses, mais aussi des (ex)détenu-e-s, des femmes, des enfants, et des travailleurs-euse-s précaires. Le projet de charte des droits provinciale rendu public par la LDL en 1973 témoigne de cette nouvelle orientation. Imprimé à 500 000 exemplaires, ce document inspiré du droit international des droits humains reconnaît à la fois les droits civils et politiques (DCP), certains droits collectifs (notamment linguistiques) et les droits économiques, sociaux et culturels (DESC). Appuyée par plusieurs groupes de la société civile, la campagne menée par la LDL est directement à l’origine de l’adoption de la Charte québécoise des droits et libertés de la personne de 1975, et de la mise sur pied de la Commission des droits de la personne, l’année suivante. Si cette loi quasi constitutionnelle est considérée encore aujourd’hui comme un document unique dans l’histoire législative canadienne, c’est en grande partie parce qu’elle incarne la conception progressiste des droits humains portée à l’époque par la LDL5. Cette dernière jouera d’ailleurs un rôle crucial dans les développements ultérieurs de ce document et dans la défense des principes qui y sont énoncés. L’engagement de la LDL pour défendre les droits des groupes discriminés et marginalisés l’amène à prendre des positions avant-gardistes, souvent impopulaires en leur temps. En 1972, elle met sur pied l’Office des droits des détenus (ODD), dans un contexte où la population se soucie peu du sort des prisonnier-ière-s et où l’incarcération est synonyme de suppression complète des droits fondamentaux. Se faisant la porte-parole des revendications des détenu-e-s, l’ODD contribue à attirer l’attention du public et des gouvernements sur la réalité opaque des prisons. Encore aujourd’hui, la LDL continue de se porter à la défense des droits des personnes incarcérées, comme en attestent notamment ses actions actuelles contre les conditions inhumaines de détention à la prison Leclerc à Laval, de même que ses positions récentes sur la situation des prisonnier-ière-s pendant la pandémie de COVID-19 et contre la détention administrative des personnes migrantes au Canada. La LDL soutient aussi très tôt les membres des communautés LGBTQ+ dans leur combat contre la discrimination, la criminalisation et la répression policière. En collaboration avec l’Association pour les droits des gai(e)s du Québec, elle sera à l’origine de l’inclusion, en 1977, de l’orientation sexuelle parmi les motifs de discrimination prohibés dans la Charte québécoise. L’organisation soutient également les luttes pionnières contre le racisme et la discrimination menées par les communautés ethniques et racisées au Québec. Dans les années 1970 et 1980, elle appuie les combats de la communauté haïtienne contre le racisme et la discrimination en milieu de travail (notamment dans l’industrie du taxi) et s’implique activement dans les coalitions initiées par des membres des communautés racisées pour dénoncer le profilage racial et les abus commis par la police. Ces campagnes s’inscrivent dans le prolongement de l’engagement tenace de la Ligue dans la défense des droits des personnes réfugiées et sans-statut, qui a débuté dans la foulée de ses combats pour l’accueil des réfugié-e-s haïtiens et chiliens fuyant les dictatures des Duvalier et de Pinochet, au début des années 1970. Depuis plusieurs années, la LDL milite pour faire reconnaître et combattre le racisme systémique au Québec, passant d’une approche centrée sur le combat contre les pratiques discriminatoires vers une perspective plus large fondée sur le combat contre l’ensemble des violations de droits engendrées par le racisme, en tant que système.La thématique des Droits en mouvements nous rappelle également que les avancées en matière de droits humains ne doivent jamais être considérées comme des acquis.La période des années 1970 est aussi marquée par une implication croissante de la LDL dans la défense des droits ancestraux, territoriaux, issus de traités et à l’autodétermination des peuples autochtones. En plus de soutenir les revendications des Autochtones, de sensibiliser les allochtones à leur réalité et de favoriser l’établissement d’un dialogue de nations à nation, la LDL dénonce régulièrement les violations des droits commises envers les communautés, n’hésitant pas à faire appel à des organisations internationales comme la Fédération internationale pour les droits humains (FIDH) pour alerter la communauté internationale. Active à l’ONU dans les travaux entourant l’adoption de la Déclaration des Nations Unies sur les droits des peuples autochtones (2007), la LDL continue aujourd’hui d’appuyer les Autochtones dans leur combat pour l’autodétermination, en dénonçant le (néo)colonialisme et les violations de droits humains qui lui sont inhérentes.

L’interdépendance des droits… et des luttes

La LDL se distingue d’autres organisations de défense des droits par l’importance qu’elle accorde aux droits économiques, sociaux et culturels (DESC). Dans la foulée du tournant néolibéral des années 1980, particulièrement, elle dénonce régulièrement les saccages des politiques sociales et les pratiques de surveillance et de répression dirigées contre les prestataires de l’État. Aux côtés d’organismes comme le Front commun des personnes assistées sociales du Québec, le Front d’action populaire en réaménagement urbain ou le Regroupement des comités logement et associations de locataires du Québec, la LDL prend une part active dans la défense de l’ensemble des droits inscrits au Pacte international relatif aux droits économiques, sociaux et culturels (PIDESC)6. Depuis le début des années 1990, la LDL a d’ailleurs présenté trois rapports alternatifs sur la situation des DESC au Canada devant le Comité des droits économiques, sociaux et culturels de l’ONU chargé de surveiller la mise en œuvre du PIDESC. Dans la foulée du Programme d’action de Vienne de 1993, la LDL inscrit le principe de l’interdépendance de tous les droits humains au cœur de sa mission. Cette approche, qui postule que les avancées et reculs en matière de protection d’un droit ont des conséquences sur l’ensemble des autres droits, appelle également une compréhension nouvelle de la complémentarité de nos luttes pour la défense collective de tous les droits. Appuyé par près d’une cinquantaine d’organisations, le Rapport sur l’état des droits humains au Québec et au Canada publié par la LDL en 2013 incarne la volonté de ses militant-e-s de créer un mouvement social large pour construire une société permettant la réalisation de l’ensemble des droits humains. Cet effort collectif apparaît d’autant plus crucial aujourd'hui, alors que nous assistons à une montée en force des mouvements anti-droits humains, à une récupération politique du discours des droits par des mouvements de droite et à des attaques répétées, de la part des gouvernements, aux droits humains et aux chartes qui sont censées les promouvoir et les protéger.Crises et droits humains… une vigilance constante

La thématique des Droits en mouvements nous rappelle également que les avancées en matière de droits humains ne doivent jamais être considérées comme des acquis. L’histoire nous démontre en effet que, pour paraphraser la formule célèbre de Simone de Beauvoir, il ne suffit parfois que d’une crise (réelle, appréhendée ou même fabriquée) pour que ces droits soient remis en cause, fragilisés, voire carrément foulés aux pieds. À plusieurs reprises, la LDL et ses alliés ont été confrontés à cet état de fait. De nombreuses violations de droits ont notamment été commises à différentes époques au nom de la préservation de la sécurité nationale. Les entorses aux droits fondamentaux perpétrées au nom de la guerre au terrorisme, au lendemain des attentats du 11 septembre 2001, par exemple, ne sont pas sans rappeler les pratiques d’internement lors des deux guerres mondiales, les politiques liberticides contre les communistes pendant la guerre froide, l’emprisonnement des groupes nationalistes et radicaux dans les années 1960, les rafles de la Crise d’octobre 1970, ou encore la surveillance des syndicats et des groupes de gauche (y compris de la LDL) pendant les décennies 1970 et 1980. La crise d’Oka, à l’été 1990, témoigne aussi de l’extrême fragilité des droits lorsque l’état d’urgence est invoqué par les forces de maintien de l’ordre. Les six décennies d’histoire de la LDL montrent aussi combien les droits fondamentaux sont mis à mal en périodes de crises sociales ou politiques. Ainsi, lors du printemps érable de 2012, la LDL a dénoncé fermement la répression policière et les entorses aux droits fondamentaux de s’exprimer, de circuler, de manifester et de se réunir de manière pacifique. Cette lutte paraissait d’autant plus vitale qu’elle s’inscrivait alors en soutien à un mouvement pour la défense du droit à l’éducation. À plusieurs reprises, la LDL s’est portée à la défense des droits démocratiques; que l’on songe à son rôle d’observatrice des libertés civiles lors du Sommet des Amériques en 2001 et des Sommets du G20 à Toronto (2010) et du G7 à Charlevoix (2018). Plusieurs crises imaginaires ou fabriquées ont également servi de prétexte, à différentes époques, pour justifier des atteintes aux droits des minorités ou des groupes marginalisés. En 2007, par exemple, la soi-disant crise des accommodements raisonnables a favorisé la diffusion de discours islamophobes et contribué à créer un courant d’opinion favorable à l’adoption de lois discriminatoires contre les personnes musulmanes. L’actuelle crise migratoire sert des desseins analogues, étant instrumentalisée par l’État pour justifier la fermeture des frontières, le renforcement des logiques carcérales de gestion des personnes migrantes et la mise en place d’un arsenal répressif portant atteinte à leur dignité et à leurs droits. Bien que ses impacts délétères sur la santé et la vie humaines soient indéniables, la pandémie de la COVID-19 s’ajoute à cette longue liste d’exemples de violations disproportionnées des droits en période de crise, et en particulier à ceux des personnes les plus vulnérables. Tracer la généalogie de ces crises suffit à démontrer que ce qui est présenté comme urgent, temporaire ou exceptionnel, prend de fait des allures de permanence. Chaque fois, ces crises ont révélé la fragilité des droits humains, mais aussi la difficulté de les défendre lorsque le maintien de l’ordre, les intérêts de la majorité, les droits dits collectifs, la paix sociale ou la sécurité nationale sont invoqués pour justifier leur violation. L’histoire de la LDL et du mouvement des droits humains montre que le projet de société porté par cet idéal, par l’ampleur des défis qu’il impose, doit regrouper toutes les forces progressistes engagées dans le combat pour une société plus juste. Car, comme tout ce qui doit demeurer vivant, nos luttes se doivent d’être collectives, solidaires et en prise sur notre monde en mouvements.- Ross Lambertson, Repression and Resistance : Canadian Human Rights Activists, 1930-1960. Toronto, University of Toronto Press, 2005, 523

- Paul-Etienne Rainville, De l’universel au particulier : les luttes en faveur des droits humains au Québec (1945-1964). Thèse de doctorat (histoire), Université du Québec à Trois-Rivières, 2018, 596

- Commission d’enquête sur l’administration de la justice en matière criminelle et pénale au Québec; Yves Prévost. La société face au crime. Québec, Éditeur officiel du Québec,

- Ligue des droits de l’homme, Rapport annuel, mai 1973 à mai 1974, 13 ; Marie-Laurence B.-Beaumier, Le genre et les limites de l’universalité : La Ligue des Droits de l’Homme du Québec, 1963-1985, Mémoire (histoire), Université Laval, 2013, 153 p.

- Pierre Bosset, La Charte québécoise : Le rôle crucial de la Ligue, dans : Au cœur des luttes (1963-2013). La Ligue des droits et libertés, 50 ans d’action. Montréal, LDL, 2013, 21-24.

- Pacte international relatif aux droits économiques, sociaux et Voir : Assemblée générale des Nations Unies, résolution 2200 A (XXI), 16 décembre 1966. En ligne : http://www.ohchr.org/FR/ProfessionalInterest/Pages/CCPR.aspx

L’article 60 ans de luttes pour les droits humains est apparu en premier sur Ligue des droits et libertés.

Un contre-pouvoir essentiel

Éditorial

Stéphanie Mayer, Enseignante de science politique au collégial, vice-présidente de la Ligue des droits et libertésRetour à la table des matières Revue Droits et libertés, printemps / été 2023

Une première signification de Droits en mouvements réfère aux personnes engagées un peu partout dans le monde en faveur des droits humains; elles produisent des mouvements opposés à l’injuste statu quo. Elles constituent une force sociale rassembleuse qui traverse le temps, car – rappelons-le – les origines de ces mouvements précèdent l’inscription des droits dans la Charte internationale des droits de l’homme1.

Si la Ligue des droits et libertés (LDL)2 souligne ses six décennies d’existence, il faut noter que la Fédération internationale pour les droits humains a fêté ses 100 ans en mai 2022 et que la Déclaration universelle des droits de l’homme célébrera son 75e anniversaire en décembre 2023.Si les droits sont universels, indivisibles et inaliénables, il incombe à l’État d’en assurer le respect et, plus encore, de mettre en place les conditions écono- miques, culturelles, sociales et poli- tiques nécessaires à leur réalisation. Malheureusement, les États contournent ou bafouent trop souvent les chartes ratifiées, c’est pourquoi un contre-pouvoir est essentiel. Ce dernier est toutefois menacé dans certaines régions du globe. À titre d’exemples : en décembre 2021, la justice russe a ordonné la dissolution du Centre des droits humains de l’ONG Mémorial qui recense les violations de droits en Russie3 ; en janvier 2023, la Ligue algérienne de défense des droits de l’Homme a été dissoute par les autorités du pays pour jouer son rôle de défense de la démocratie et des libertés4 ; en avril 2023, le sénateur français Gérald Darmanin a menacé de revoir les subventions publiques offertes à la Ligue des droits de l’homme après avoir été interrogé par cette dernière sur l’usage excessif des forces de l’ordre pour réprimer des manifestations en France5. Dans ce contexte, la LDL continue et continuera d’assumer ce rôle de contre-pouvoir alors que notre conjoncture politique est marquée par des gouvernements qui s’attaquent explicitement aux chartes des droits, que ce soit en modifiant le contenu ou en utilisant la clause dérogatoire. La montée des droites et l’éventuel retour d’un gouvernement conservateur à Ottawa n’augurent rien de bon pour le respect des droits humains. Depuis sa fondation, la LDL défend un ambitieux projet de société fondé sur les droits humains et elle est consciente des forces réactionnaires empressées de crier aux excès d’égalité, aux abus du système par des minorités ou à la remise en question de certains de leurs privilèges. Il s’agit là d’une deuxième signification de Droits en mouvements : les mouvements générés par les forces sociales en présence. Rappelons quelques éléments : que les droits ne sont pas offerts généreusement par les autorités, mais gagnés par les titulaires de droits avec des luttes politiques concrètes ; que les avancées en droits doivent être universelles, sinon elles demeurent des privilèges ; que les droits ne sont pas obtenus de manière linéaire comme laisse présager l’idée même de progrès, car à tous moments, des forces réactionnaires peuvent entrainer des reculs.

La vigilance des personnes militantes de la LDL permet d’identifier les sources de violation de droits en proposant des contre-discours.En se fondant sur le cadre de référence des droits humains, ces argumentaires offrent des regards originaux sur des questions d’actualité telles que la migration, les frontières et la citoyenneté ; les enjeux d’interpellations policières, de surveillance et d’incarcération des personnes ; les manifestations de racisme et de profilage racial et social ; la militarisation galopante et les menaces potentielles à notre sécurité ; la désaffection par l’État des services publics qui affectent en chaine les droits à la santé, à l’éducation, au logement, à la culture, etc. Ensemble, ces contre-discours et ce contre-pouvoir caractérisent bien le travail politique réalisé par la LDL depuis 1963. Une autre signification de Droits en mouvements rappelle qu’une fois les droits humains reconnus, inscrits et enchâssés dans un texte officiel, ils ne sont pas statiques. L’interdépendance des droits humains suppose que la réalisation d’un droit est conditionnelle à la réalisation d’autres droits et que la violation de l’un de ceux-ci peut constituer une atteinte à plusieurs.

Pour que personne ne soit laissé derrière, les droits doivent être respectés en tenant compte que les conditions nécessaires à leur réalisation se modifient au gré des défis que confrontent les sociétés.Notamment, les crises écologiques qui nous assaillent, mais également toutes les mesures de transitions énergétiques à mettre véritablement en place, doivent être analysées à partir de l’interdépendance des droits humains, car les conséquences de ces crises promettent d’affecter l’ensemble des droits. La question environnementale relève de l’avenir humain et démontre la portée de ce cadre de référence et de son adaptabilité à tous les enjeux rencontrés par nos sociétés. Ce numéro de la revue Droits et libertés vise différents objectifs : informer ses membres, jeunes et moins jeunes, sur les origines politiques de la LDL ainsi que sur son cadre de référence qui est l’interdépendance des droits ; apprécier les avancées en matière de droits auxquelles elle a contribué depuis sa fondation en 1963 ; rappeler les ressacs et l’existence de forces réactionnaires ; et surtout, inciter à la réflexion sur les luttes qui nous attendent. Plus particulièrement, ce numéro rassemble tant des textes survolant l’historique du travail de la LDL que des textes tournés vers l’avenir, portant sur différentes luttes que la LDL a menées au cours de son existence.

La transmission de la mémoire militante est garante de la poursuite de notre projet collectif de défense des droits humains.Des individus toujours plus nombreux rejoignent les mobilisations en faveur des droits humains, formant des mouvements essentiels à l’édification de sociétés épanouissantes fondées sur l’égalité, les libertés et la justice sociale. L’histoire de la LDL est celle de solidarités constituées en un large réseau, une mosaïque d’individus, de groupes et d’organisations de différents milieux, dont les énergies militantes et les expertises sont la force motrice. Merci à vous, toutes et chacun qui croyez, soutenez et participez à la réalisation de la mission de promotion et de défense des droits. Le soixantième anniversaire de la Ligue des droits et libertés est celui de nos solidarités et de notre projet de société fondé sur l’idéal des droits humains. Bonnes célébrations et surtout, bonne lecture !

- Cette Charte est constituée de la Déclaration universelle des droits de l’homme, du Pacte international des droits civils et politiques et du Pacte international des droits économiques, sociaux et culturels.

- Dans cette publication, le nom Ligue des droits et libertés et le sigle LDL, ont été utilisés pour référer à la Ligue des droits de l’homme.

- Agence France-Presse, La justice russe achève de dissoudre l’ONG Mémorial, Radio-Canada, 29 décembre 2021. En ligne : https://ici.radio-canada.ca/nouvelle/1850690/russie-justice-politique-droits-memorial

- Agence France-Presse, La principale ligue des droits de la personne dissoute par les autorités, La Presse, 22 janvier 2023. En ligne : https://www.lapresse.ca/international/afrique/2023-01-22/algerie/la-principale-ligue-des-droits-de-la-personne-dissoute-par-les-autorites.php

- Darame et J. Lamothe, Gérald Darmanin menace de remettre en question les subventions publiques accordées à la Ligue des droits de l’homme, Le Monde, 6 avril 2023. En ligne : https://www.lemonde.fr/politique/article/2023/04/05/gerald-darmanin-menace-de-remettre-en-question-les-subventions-publiques-accordees-a-la-ldh_6168412_823448.html

L’article Un contre-pouvoir essentiel est apparu en premier sur Ligue des droits et libertés.

60 ans de la Ligue des droits et libertés – Droits en mouvements

Communiqué de presse Pour diffusion immédiate

60 ans de la Ligue des droits et libertés – Droits en mouvements Vernissage de l’exposition et lancement de la revue

Montréal, le 29 mai 2023 – Fondée le 29 mai 1963, la Ligue des droits et libertés (LDL) célèbre aujourd’hui même 60 ans d’existence par le vernissage de l’exposition Droits en mouvements et le lancement d’une édition spéciale de la revue Droits et libertés à l’Écomusée du fier monde à Montréal. L’exposition se tiendra jusqu’au 3 septembre 2023. À travers une sélection d’archives de la Ligue des droits et libertés (LDL), cette exposition met en lumière les débuts de la Ligue des droits de l’homme, qui réunissait un groupe de personnes animées par la défense de la démocratie, de l’État de droit et des libertés civiles dans le Québec de la Grande Noirceur. L’une des victoires marquantes de la jeune organisation a été la vaste campagne menée pour donner naissance à la Charte des droits et libertés de la personne, adoptée en 1975. L’exposition jette aussi un éclairage sur le rôle des mouvements sociaux depuis 60 ans dans l’avancement des droits, l’évolution des luttes et surtout, la dimension profondément collective du projet de société porté par l’idéal des droits humains. En complément de l’exposition, un numéro spécial de Droits et libertés explore les principaux champs d’intervention actuels de la LDL, à travers des textes historiques et des textes portés vers l’avenir qui présentent des réflexions à propos des luttes et de grands enjeux du monde de demain. La Ligue des droits et libertés tient à remercier toutes les organisations qui soutiennent la réalisation de l’exposition et de la revue : Desjardins, la Caisse d’économie solidaire, la coopérative financière des entreprises collectives au Québec ; la Fondation Lucie et André Chagnon ; la Fondation Léo-Cormier ; Inter Pares ; le Syndicat des professionnelles et professionnels du gouvernement du Québec (SPGQ) ; le Conseil central du Montréal métropolitain de la CSN ; la Confédération des syndicats nationaux (CSN) ; la Fédération interprofessionnelle de la santé du Québec (FIQ); la Fédération autonome de l’enseignement (FAE) ; le Centre de recherches interdisciplinaires en études montréalaises (CRIEM); le Centre d’histoire des régulations sociales (CHRS); le Fonds de recherche du Québec - Société et Culture (FRQSC) ; le Groupe d’histoire de Montréal ; Daniel Weinstock, titulaire de la Chaire Katharine A. Pearson en société civile et politiques publiques ; le Service des archives et de gestion des documents de l’UQÀM et l’Écomusée du fier monde. Citations « Célébrer 60 ans d’existence, c’est l’occasion de mesurer le chemin parcouru. C’est aussi celle de prendre conscience de ce qui reste encore à faire pour que toutes et tous puissent jouir de l’ensemble des droits. » - Diane Lamoureux, commissaire de l’exposition, membre du comité de direction de la revue et membre du conseil d’administration de la LDL. « L’histoire de la LDL est faite de reculs et d’avancées, de ressacs et de victoires. C’est une histoire de résistance, de patience, de persévérance... Cette exposition rend hommage aux groupes et aux mouvements sociaux qui ont combattu pour l’avancement des droits humains au Québec. C'est aussi un appel à la mobilisation, à la convergence des luttes et à l'engagement pour défendre la liberté, l'égalité et la justice sociale. » - Paul-Etienne Rainville, historien, commissaire de l’exposition, membre du comité de direction de la revue et membre du conseil d’administration de la LDL. Faits saillants La revue Droits et libertés est disponible auprès de la Ligue des droits et libertés et de quelques librairies. Exposition Droits en mouvements Date 29 mai au 3 septembre 2023 Lieu : Écomusée du fier monde, 2050, rue Atateken, métro Berri-UQÀM Tarifs : 6 $ à 12 $ Horaire : Mercredi (11 h – 20 h) Jeudi et vendredi (9 h 30 – 17 h) Samedi et dimanche (10 h 30 – 17 h) Pour information, 514 528-8444 | info@ecomusee.qc.ca. -30- À propos de la Ligue des droits et libertés Depuis 1963, la Ligue des droits et libertés (LDL) a influencé plusieurs politiques gouvernementales et projets de loi en plus de contribuer à la création d’institutions vouées à la défense et la promotion des droits humains. Elle intervient régulièrement dans l’espace public pour porter des revendications et dénoncer des violations de droits auprès des instances gouvernementales sur la scène locale, nationale ou internationale. Son travail d’analyse, de sensibilisation et de promotion est primordial pour que les droits humains deviennent la voie à suivre vers une société juste et inclusive, pour tous et toutes. Comme organisme sans but lucratif, indépendant et non partisan, la LDL vise à défendre et à promouvoir l’universalité, l’indivisibilité et l’interdépendance des droits reconnus dans la Charte internationale des droits de l’homme. Pour informations, entrevues et exemplaire de la revue Droits et libertés Elisabeth Dupuis, Responsable des communications de la Ligue des droits et libertés Cellulaire : 514-715-7727L’article 60 ans de la Ligue des droits et libertés – Droits en mouvements est apparu en premier sur Ligue des droits et libertés.

Droits en mouvements | Revue Droits et libertés

Fondée en 1963, en plein coeur de la Révolution tranquille, la Ligue des droits et libertés (LDL) a été au centre des grandes luttes sociales, juridiques et politiques qui ont jalonné l’histoire du Québec contemporain. Sous le thème Droits en mouvements, son 60e anniversaire est l’occasion de mettre en valeur le rôle des mouvements sociaux dans l’avancement des droits, le caractère évolutif de nos luttes et, surtout, la dimension profondément collective du projet de société porté par l’idéal des droits humains.

Ce numéro spécial de Droits et libertés explore les principaux champs d’intervention actuels de la LDL, à travers deux types de textes. Accompagnés de documents d’archives, certains textes adoptent une perspective historique, en présentant des panoramas des luttes menées dans ces différents domaines par la LDL depuis sa fondation. Portant leur regard vers l’avenir, d’autres textes proposent des réflexions sur l’évolution de ces luttes face aux grands enjeux du monde de demain.

Consulter la table des matières

Avec ce numéro, la LDL rappelle que la continuité et l’imbrication de nos luttes demeurent la condition essentielle à la réalisation du principe de l’interdépendance de tous les droits, qui guide aujourd’hui l’ensemble de ses actions.

Cette édition spéciale de la revue Droits et libertés est une publication de la Ligue des droits et libertés, réalisée avec l’appui financier de la Fondation Léo-Cormier et du Fonds de recherche du Québec - Société et Culture (FRQSC), en collaboration avec le Centre de recherches interdisciplinaires en études montréalaises (CRIEM) et le Service des archives et de gestion des documents de l’UQÀM.

Procurez-vous le nouveau numéro de la revue!

-

- Imprimée : 15 $ en librairie ou directement à la LDL

- Imprimée incluant livraison : 20 $ incluant les frais de poste

Devenez membre de la LDL pour recevoir deux numéros de Droits et libertés par année

Dans ce numéro

Télécharger le PDF

Éditorial

Un contre-pouvoir essentiel

Stéphanie Mayer

Histoire de la Ligue des droits et libertés

60 ans de luttes pour les droits humains

Paul-Etienne Rainville

Liberté d’expression et droit de manifester

Défendre des espaces de contestation sociale

Lynda Khelil

La liberté d’expression dans tous ses états

Laurence Guénette

Pratiques policières

Une police en porte-à-faux avec les droits

Lynda Khelil

Peut-on être en sécurité en faisant fi des droits?

Lynda Khelil et Diane Lamoureux

Surveillance des populations

L'essor de la société de surveillance

Dominique Peschard

À l’ère du capitalisme de surveillance

Dominique Peschard

Enjeux carcéraux

Les prisons : lieux de violations de droits

Lynda Khelil

La prison est violences

Me Delphine Gauthier-Boiteau, Me Sylvie Bordelais et Me Amélie Morin

Racisme et exclusion sociale

Lutter pour le droit à l’égalité effective

Martine Éloy

Institution frontalière ou droit aux droits

Mouloud Idir

Droits des peuples autochtones

Les mobilisations des peuples autochtones

Gérald McKenzie

Concrétiser l’autodétermination

Entrevue avec Me Alexis Wawanoloath par Elisabeth Dupuis

Droits économiques et sociaux

Cent fois sur le métier…

Me Lucie Lamarche

Tisser un projet de société

Laurence Guénette

Environnement et droits humains

L’environnement et l’interdépendance des droits

Article de Karina Toupin rédigé à partir d’un texte de Sylvie Paquerot

La démocratie au coeur de la transition

Laurence Guénette et Frédéric Legault

L’avenir des droits humains

La vie sociale des droits

Diane Lamoureux

L’inestimable valeur des droits humains

Alexandra Pierre

Reproduction de la revue

L’objectif premier de la revue Droits et libertés est d’alimenter la réflexion sur différents enjeux de droits humains. Ainsi, la reproduction totale ou partielle de la revue est non seulement permise, mais encouragée, à condition de mentionner la source.

L’article Droits en mouvements | Revue Droits et libertés est apparu en premier sur Ligue des droits et libertés.

Renforcement de la vie privée et éthique du design numérique

Retour à la table des matières Revue Droits et libertés, printemps / été 2022

Renforcement de la vie privée et éthique du design numérique

Michelle Albert-Rochette, candidate à la maîtrise en droit, Université Laval Marie-Pier Jolicoeur, candidate au doctorat en droit du design numérique, Université Laval Shoshana Zuboff dénonce, dans son ouvrage The Age of Surveillance Capitalism, un modèle économique basé sur l’extraction de nos données personnelles1. Dans cette nouvelle forme de capitalisme, la professeure Zuboff expose que l’on cherche, de toutes les manières possibles et pour des motifs économiques, à ce que les personnes passent le plus de temps possible en ligne afin de générer toujours plus de données2. La collecte et le traitement d’une quantité massive de données permettent ultimement aux grandes entreprises de mieux prédire et contrôler le comportement des personnes3. Les outils technologiques et les médias sociaux que nous utilisons quotidiennement sont ainsi mis au service de l’addiction by design4, soit l’objectif de créer une propension à utiliser continuellement ces technologies. L’objet de ce court article n’est pas de proposer des pistes de solution révolutionnaires au modèle décrit par la professeure Zuboff, mais plutôt d’ouvrir les lectrices et lecteurs à de nouvelles perspectives. Nous décrirons donc certaines initiatives qui visent à créer un environnement numérique davantage respectueux de la vie privée et des vulnérabilités humaines. Nous présentons d’abord, dans une perspective critique, quelques propositions juridiques. Ensuite, nous proposons un court examen du thème de l’éthique du numérique.Aperçu du projet de loi 64

Le projet de loi 645 (PL 64), adopté le 21 septembre 2021, a modifié la loi québécoise de protection des renseignements personnels6 (RP) dans le secteur privé. Un de ses objectifs est d’accroître le contrôle qu’ont les personnes sur leurs données. Les modifications introduites par PL 64 s’intéressent notamment aux pratiques de profilage en imposant de nouvelles obligations aux entreprises, qui devront désormais avertir les personnes et les informer des moyens dont elles disposent pour activer les fonctions de profilage7, comme la publicité ciblée. Le PL 64 a aussi introduit des exigences à l’obtention du consentement pour la collecte, l’utilisation ou la communication de RP8. Le but est de mieux informer les personnes pour les protéger en leur permettant de faire des choix éclairés. Ces modifications paraissent positives, mais on peut douter de leur utilité : même si le consentement est renforcé par l’introduction de nouvelles normes, ce mécanisme demeure ancré dans une vision individualiste de la vie privée peu adaptée au fonctionnement du capitalisme de surveillance. En effet, à l’ère du numérique, il est peu praticable de refuser son consentement. On peut par exemple penser à la nécessité d’accepter les politiques de confidentialité de Facebook pour accéder à différents services et pour entretenir des liens sociaux9. Le mécanisme de consentement individuel occulte par ailleurs les effets systémiques liés au traitement des données. Au moment de consentir, on peut difficilement imaginer ce que ses données peuvent révéler sur soi lorsqu’elles sont croisées avec des milliards d’autres10. On ne peut non plus appréhender le pouvoir que confère aux entreprises le cumul de données d’apparence anodine11. Et même si un consentement était réellement libre et éclairé, ce choix individuel a des effets collectifs puisqu’il permet d’inférer des informations sur les autres : « [b]y consenting […] a user becomes a conduit for gathering information about her entire social network, whether or not they have consented12».Le mécanisme de consentement individuel occulte par ailleurs les effets systémiques liés au traitement des données.

Vers des solutions collectives

Face à ces limites, des autrices et auteurs ont envisagé des solutions qui s’écartent de la perspective dominante de contrôle individuel des données, parmi lesquelles figurent les fiducies de données13 – qui consistent en une mise en commun de données gérées par un tiers indépendant agissant pour le compte des personnes – et le devoir de loyauté (duty of loyalty 14). Cette deuxième solution cherche à garantir que les entreprises qui collectent et traitent les données agissent conformément à la confiance que les personnes leur accordent. Un réseau social assujetti à une telle obligation devrait donc agir selon les attentes raisonnables des personnes relativement à l’utilisation de leurs données et à leur expérience en ligne15. Ainsi, l’utilisation des données à des fins de publicité contextuelle serait loyale, mais pas celle réalisée à des fins de publicité comportementale. Par exemple, une personne consultant un site de voyage sur un pays donné pourrait s’attendre à recevoir de la publicité en lien avec ce pays, mais il serait déloyal pour une entreprise de diffuser une publicité basée sur le traitement de nombreux types de données issues de sources variées16. En matière d’expérience en ligne, le devoir de loyauté pourrait aussi inclure une exigence d’influence loyale17, où les entreprises ne pourraient pas concevoir un design visant à manipuler le comportement des personnes à l’encontre de leurs intérêts. L’imposition d’un tel devoir de loyauté aurait pour avantage de protéger les personnes indépendamment de leur niveau de compréhension des politiques de confidentialité18.Pour une éthique du numérique

Dans un article de 2018 s’intéressant au capitalisme de surveillance et visant à mettre en lumière le processus par lequel l’IA parvient à collecter nos données personnelles, le professeur Pierre-Luc Déziel émettait certaines réserves sur la capacité de la législation canadienne à protéger à elle seule notre vie privée :Au cours des dernières années, de nouveaux droits visant la protection de la vie privée informationnelle des personnes firent leur apparition : droit à l’explication, droit à la portabilité des données et le fameux droit à l’oubli. Ces droits [...] pourraient aider les personnes à mieux protéger leur vie privée dans les environnements numériques. Toutefois, je crois que, pour répondre aux défis soulevés [...], le droit à la vie privée ne peut agir seul, et que d’autres pans du droit peuvent et doivent être mobilisés19.

Pour compléter ce court article, il nous apparaît intéressant de nous ouvrir aux enjeux entourant l’éthique du numérique. Pour les programmeuses et programmeurs informatiques, réfléchir à ce qu’est un bon code informatique est fondamental20, mais cette question ne se limite plus seulement à la création d’outils efficaces et performants. De nouveaux concepts comme celui de Privacy by design, Safety by design et Éthique by design, qui répondent à des questions morales et de devoir- être de l’objet technique21, ont vu le jour. La PhD Flora Fisher explique que la prolifération des termes by design dans les dernières décennies révèle l’existence de nouveaux concepts polysémiques obligeant à entamer une réflexion sur l’éthique virtuelle et sa puissance normative22. Très sommairement, l’idée serait, dans le cas de la vie privée, de tenir compte dès la phase de conception des systèmes informatiques, des exigences en matière de protection des données personnelles en les intégrant directement dans le produit, au lieu de les ajouter ultérieurement23. On chercherait donc à limiter, a priori, la divulgation de données collectées24. Pour Lawrence Lessig, professeur de droit à Harvard, le code informatique a une force équivalente à celle de la loi puisque le design du numérique impose de produire certains comportements. Ce code constitue également un levier important pour protéger les droits de ces utilisatrices et utilisateurs25. En somme, s’il l’on veut réellement avoir un impact pour améliorer les choses à long terme, c’est à l’architecture même du code informatique, au design du numérique, qu’il faudra s’intéresser, pour éviter que les solutions avancées soient de simples coups d’épée dans l’eau.Très sommairement, l’idée serait, dans le cas de la vie privée, de tenir compte dès la phase de conception des systèmes informatiques, des exigences en matière de protection des données personnelles en les intégrant directement dans le produit, au lieu de les ajouter ultérieurement.

- S. Zuboff, The Age of Surveillance Capitalism. The Fight for a Human Future at the New Frontier of Power, PublicAffairs, New York, 2019.

- Id.

- N. Richards et W. Hartzog, A Duty of Loyalty for Privacy Law, 2021, 99 Wash.U. L. Rev. 961, p. 18

- N. D. Schüll, Addiction by design, Princeton University Press, 2012.

- Loi modernisant des dispositions législatives en matière de protection des renseignements personnels (Loi modernisant la loi sur le privé).

- Loi sur la protection des renseignements personnels dans le secteur privé.

- Loi modernisant la loi sur le privé, 8.1.

- Id, 14.

- Jack Balkin,The Fiduciary Model of Privac, 2020, 134:1 HLRF 11, p. 13.

- J. A.T. Fairfield et C. Engel, Privacy as a Public Goo, 2015, 65:3 Duke L.J. 385, p. 390.

- Ex: S. Delacroix et N. D. Lawrence, Bottom-up data Trusts: disturbing the ‘one size fits all’ approach to data governance, 2019, 9:4 Int. Data Priv. Law 236, p. 237.

- A.T. Fairfield et C. Engel, supra note 10, p. 410.

- Ex : Delacroix et N. D. Lawrence, supra note 11.

- N. Richards et W. Hartzog, A Duty of Loyalty for Privacy Law, supra note 3.

- N. Richards et W. Hartzog, The Surprising Virtues of Data Loyalty, 71 ELJ (à paraître 2022), p. 8.

- Jack Balkin, supra note 10, p. 28.

- N. Richards et W. Hartzog, supra note 15, p.44.

- N. Richards et W. Hartzog, supra note 15, p. 27.

- P-L. Déziel, Les limites du droit à la vie privée à l’ère de l’intelligence artifici- elle : groupes algorithmiques, contrôle individuel et cycle de traitement de l’information, 2018, 30:3 C.P.I. 827.

L’article Renforcement de la vie privée et éthique du design numérique est apparu en premier sur Ligue des droits et libertés.

Quelles réponses, quelles ripostes au capitalisme de surveillance et monopoles

Retour à la table des matières Revue Droits et libertés, printemps / été 2022

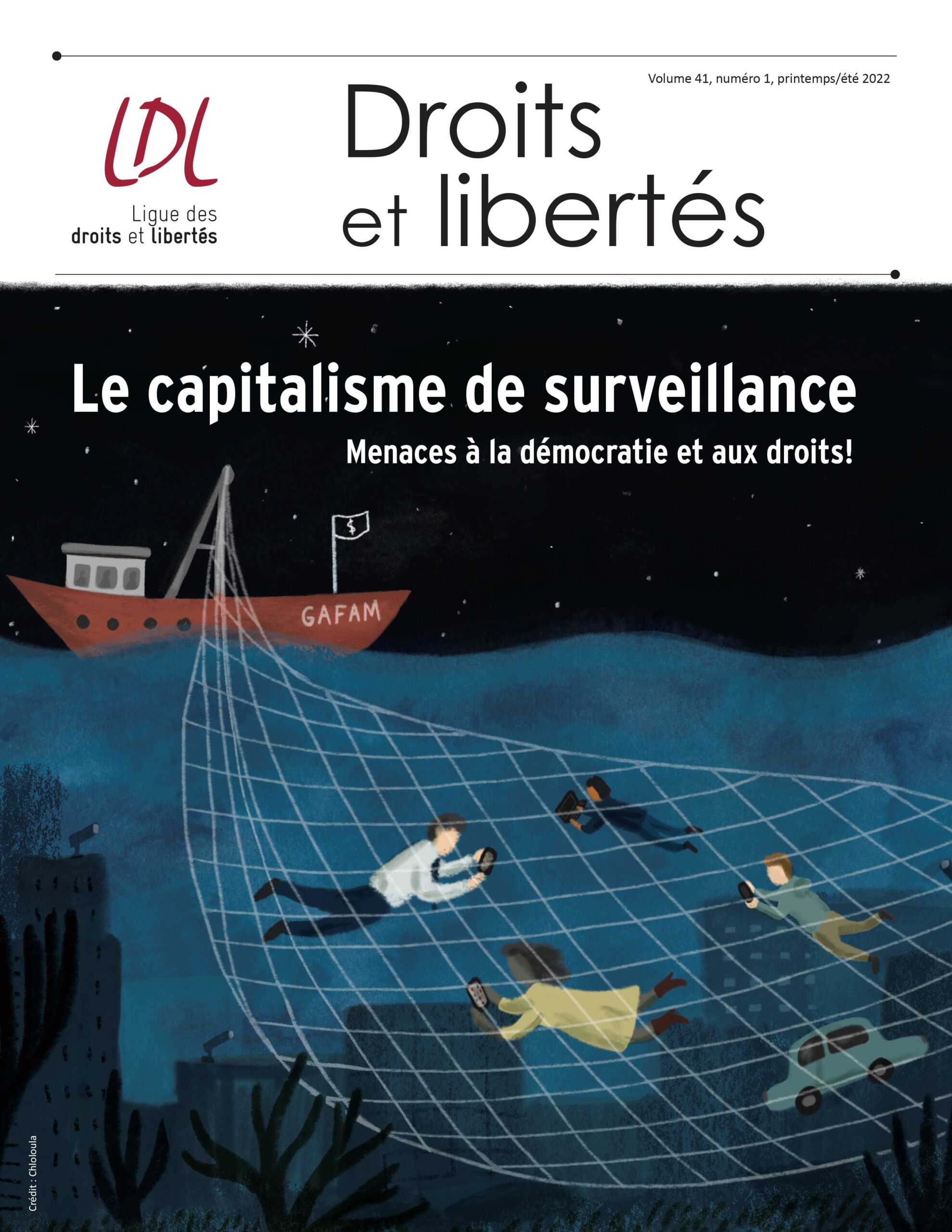

Capitalisme de surveillance et monopolisation

Quelles réponses, quelles ripostes?

Pierre Henrichon, auteur de Big Data. Faut-il avoir peur de son nombre? Le 20 octobre 2020, le procureur général des États-Unis et les procureurs généraux de 11 états (Arkansas, Floride, Georgie, Indiana, Kentucky, Louisiane, Mississippi, Missouri, Montana, Caroline du Sud, Texas) saisissaient la Cour fédérale du District de Columbia d’accusations portées contre Google alléguant des pratiques monopolistiques illégales de la part de la société-phare géante de la Silicon Valley1. Le 9 décembre 2020, la Federal Trade Commission (FTC) du gouvernement des États-Unis déposait une plainte à l’endroit de Facebook, alléguant des pratiques contraires aux lois antitrust. Entre 2011 et 2013, la FTC avait mené enquête sur le rôle de Google au sein des marchés de la recherche Internet et de la publicité en ligne. Alors que le personnel juridique de la Commission recommandait le dépôt de poursuites, l’administration en décida autrement. En fait, il faut remonter à mai 1998 pour retracer le plus récent procès contre un géant du Big Tech s’appuyant sur les dispositifs juridiques antitrust des États-Unis, et dont le jugement fit l’objet d’un appel réussi2. Et je me limite aux enquêtes et mises en accusation diligentées aux États-Unis. Elles sont légion en France, en Grande-Bretagne, en Inde et ailleurs. Alors que les poursuites intentées en vertu des lois antitrust sont les bienvenues, elles ne seront pas suffisantes pour mettre un terme à ce qu’il est convenu d’appeler le capitalisme de surveillance d’autant plus que les tribunaux américains, depuis plus de 40 ans maintenant, sont devenus bienveillants à l’égard des monopoles3,4.Un modèle d’affaires vorace en données

On le sait clairement maintenant : le modèle d’affaires des géants du numérique repose sur la collecte massive, et souvent incontrôlée, des données en vue de modeler nos comportements et même nos émotions. Comme le souligne Shoshana Zuboff, « Les marchés qui font le commerce de l’avenir humain devraient être illégaux (ils entraînent des conséquences néfastes, dangereuses et antidémocratiques, et des préjudices intolérables dans une société démocratique) tout comme le commerce d’organes humains et d’êtres humains sont illégaux)5 ». Bien que des réglementations aient été adoptées au fil des ans6, elles n’atteignent pas le cœur du modèle d’affaires des Facebook de ce monde.La socialisation des données

Dans mon essai7, j’ai proposé un régime de socialisation des données par lequel les données captées par des acteurs comme les Google, Apple, Facebook, Amazon et Microsoft (GAFAM) seraient mises en commun et proposées à des utilisateurs, sous condition de finalités socialement acceptées, qui pourraient alors les agréger et les traiter. Cela présentait l’avantage d’ouvrir l’accès à toutes ces données à des fins de recherche en santé publique, en intelligence artificielle, etc. Et cela n’interdisait pas non plus aux GAFAM de mener à bien leurs travaux... sous surveillance d’une agence de réglementation d’utilisation des données.Bien que des réglementations aient été adoptées au fil des ans, elles n’atteignent pas le cœur du modèle d’affaires des Facebook de ce monde.D’autres modèles de socialisation – volontaire cette fois – ont depuis fait l’objet de travaux et de propositions. Au Canada, la notion de fiducie de données a été avancée8. On en donnait la définition suivante : Une fiducie de données est un organisme formé pour gérer des données pour le compte de ses membres. Ces derniers mettent en commun leurs données et conviennent expressément des conditions afférentes à leur partage.9 Les finalités de telles fiducies visaient surtout l’innovation et la commercialisation des résultats.

L’intérêt général avant tout

Un autre modèle, peut-être plus prometteur, est celui du Data altruisme10 par lequel toutes les parties prenantes – contributeurs de données et utilisateurs – sont liées par des ententes encadrées en vue de partager des données à des fins identifiées comme étant en concordance avec l’intérêt général. Cette approche a déjà reçu l’aval des autorités européennes et sera probablement mise à l’épreuve au cours des prochaines années. Mais de tels régimes, aussi innovateurs et généreux soient-ils, ne mettent pas en péril la captation tous azimuts des données pratiquée par les principaux acteurs monopolistiques de l’économie numérique. Aussi, nos efforts visant le démantèlement de ces monopoles, la socialisation générale des données et la réglementation plus serrée de la commercialisation des données ne doivent-ils pas s’affaiblir.Pourquoi combattre les monopoles dans l’économie du Big Data

|

|

|

|

|

|

|

|

|

|

|

|

|

- Les tribunaux ont renvoyé les procureurs faire leurs Cela montre bien les limites de l’approche légaliste qui s’appuie sur les lois antitrust.

- United States Microsoft Corporation, 253 F.3d 34 (D.C. Cir. 2001)

- Voir : Lina Kahn, Amazon’s Antitrust Paradox, The Yale Law Journal, no 126, p. 720 (2017)

- Judge Throws Out 2 Antitrust Cases Against Facebook, New York Times, 28 juin 2021. Notons que la FTC et les procureurs du fédéral ont décidé de revenir à la charge.

- Zuboff, L’âge du capitalisme de surveillance, Zulma, 2020.

- Parmi ces réglementations, le Règlement général sur la protection des données de l’Union européenne.